На проходящей в канадском Ванкувере конференции SIGGRAPH 2014 компания Nvidia на этой неделе представила новое поколение профессиональных видеокарт Quadro. По сравнению с предшественниками почти все модели получили вдвое больше видеопамяти.

Графический чип GK110 будет использоваться в линейке карт Quadro 5x00, чип GK104, ранее входивший в Quadro K5000, перебирается в линейку 4x00. Наконец, представители серий 2x00 и 6x0 основываются на графической архитектуре Maxwell, первые среди всех моделей Quadro. Последнее говорит о том, что карты начального уровня будут наиболее энергоэффективными, при этом, как и потребительские решения GTX 750 и GTX 750Ti, они будут занимать один слот и обойдутся без коннектора PCIe для дополнительного питания. Ещё одной однослотовой картой является модель K4200. Новинки появятся в продаже осенью, их стоимость будет равна цене соответствующих моделей нынешнего поколения.

Теги:

nVidia, видеокарты, Quadro.

На конференции SIGGRAPH компания Intel на этой неделе продемонстрировала преимущества выходящего в будущем году графического интерфейса Microsoft DirectX 12. Этот низкоуровневый API должен улучшить производительность всех доступных компьютерных систем, однако наибольшие плюсы от него можно получить в устройствах, где существуют ограничения на уровень TDP, энергопотребления и температуры. В планшетах эти ограничения затрагивают как центральный процессор, так и графический. Достигая предела, устройство не задействует максимально ни CPU, ни GPU, поэтому необходимо находить баланс между нагрузкой на них. В DirectX 12 использование центрального процессора снижается, за счёт чего графический получает дополнительные ресурсы. Демонстрация выполнялась на планшете Microsoft Surface Pro 3 с процессором Intel Haswell. Демонстрационный ролик включал в себя изображение 50 тысяч астероидов. В DirectX11 было получено 19 кадров в секунду, при этом ресурсы между CPU и GPU были разделены поровну. В DirectX 12 производительность выросла до 33 кадров в секунду (+74%). Такая разница может превратить игру из неудобной в комфортную. Аналогичные преимущества от использования DirectX 12 должны быть получены на смартфонах, ноутбуках и небольших компьютерах. Помимо повышения производительности, разработчики могут выбрать вариант сохранения прежней производительности при одновременном снижении энергопотребления и увеличении продолжительности автономной работы устройств.

Теги:

DirectX.

Одним из новшеств процессоров Intel Haswell является расширение набора инструкций под названием Transactional Synchronization Extensions (TSX). Его предназначением является улучшение производительности многопоточных приложений, для чего разработчикам необходимо задействовать соответствующие библиотеки. Обычных пользователей это расширение не затрагивает, поскольку TSX используется по большей части в транзакционных базах данных. Поскольку эта функциональность представлена относительно недавно, её успели задействовать лишь немногочисленные приложения. Один из разработчиков этих приложений недавно обнаружил в реализации TSX критическую ошибку, которая способна вызвать нестабильность в работе ПО. Реакцией на это открытие стало решение Intel отключить функцию на всех процессорах на архитектуре Haswell путём обновления микрокода, доставляемого через обновление прошивки материнской платы. Это обновление призвано повысить стабильность работы Haswell-систем и свидетельствует о том, что уязвимость носит аппаратный характер и не может быть исправлена путём программного обновления. Эта же ошибка затрагивает серверные процессоры Haswell-EP, чипы для энтузиастов Haswell-E и не выпущенные пока мобильные процессоры Broadwell-Y (Core M). Разработчики оставят возможность активировать TSX на серверных процессорах Xeon. Это позволит подготовить программное обеспечение с поддержкой TSX к моменту выпуска процессоров Haswell-EX и новых чипов Broadwell, где ошибка будет исправлена на аппаратном уровне.

Теги:

Intel, процессоры, Haswell, TSX.

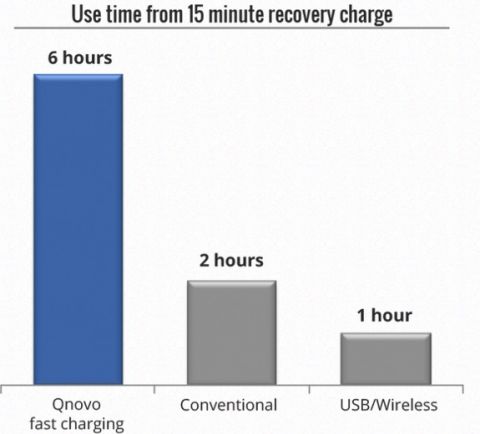

Пока одни компании и институты ищут способ создания аккумуляторов на основе новых материалов и конструкций, способных обеспечить большую продолжительность работы, другие собираются повысить эффективность работы уже имеющихся аккумуляторов. Калифорнийская компания-стартап под названием Qnovo относится как раз к числу последних: она разработала программное обеспечение QNS и чип QN200, которые совместно ведут мониторинг уровня заряда, температуры, истории подзарядки и статуса ячеек. На основе этой информации определяется оптимальное количество и направление энергии, которое должно обеспечить зарядное устройство. Вместо того, чтобы позволить току «течь непрерывным потоком», здесь используются «пакеты» энергии и проверяется статус аккумулятора для дальнейшей оптимизации процесса подзарядки. Это позволяет сократить время подзарядки на 50% и увеличить долгосрочность работы аккумуляторов, позволив избежать ущерба от излишнего тока. Этот процесс может работать и без чипа QN200, на основе только программного обеспечения. В таком случает процесс займёт больше времени, зато долгосрочность работы аккумулятора по-прежнему будет увеличена за счёт оптимизации процесса подзарядки. При этом проверка идёт примерно раз в секунду, тогда как при использовании чипа она осуществляется раз в несколько миллисекунд. 15 минут подзарядки обеспечат 6 часов автономной работы устройства В настоящее время Qnovo ведёт переговоры с рядом производителей с мобильных устройств. Часть из них собирается воспользоваться только программным обеспечение, другие готовы интегрировать в свои продукты чип QN200. Первые смартфоны с поддержкой технологии могут появиться в будущем году.

Теги:

подзарядка, Qnovo.

Распространенность смартфонов с возможностью свободного использования режима видеосъемки, а также камер вроде GoPro, сделала популярными видеоролики от первого лица, особенно сделанные во время поездок и путешествий. А в ближайшем будущем в эту когорту наверняка войдут и материалы, снятые с помощью Google Glass. Такие видеоролики бывают весьма занимательны, но у них есть одна общая проблема: сильное дрожание камеры, особенно при ускорении (так называемый формат time-lapse). Ее инновационное решение предложили специалисты из Microsoft Research. Time-lapse часто используется при монтаже видеоклипов с однотипным содержанием, например, поездкой на велосипеде или покорением какой-либо вершины. Казалось бы, тут можно вспомнить про традиционную технологию программной стабилизации изображения. Ее работа основана на обрезке пикселей по краям изображения для создания более плавного перехода между кадрами. Однако при увеличении скорости воспроизведения такой алгоритм явно не позволяет сгладить дрожание камеры. Алгоритм же, предложенный разработчиками из Microsoft Research и принадлежащий к формату hyperlapse, является гораздо более сложным, однако и эффективность его впечатляет. Работает он следующим образом. Сначала выполняется реконструкция движения камеры в 3D с расчетом ее расстояния и угла наклона к окружающим объектам. Затем алгоритм «рисует» более плавный маршрут движения и склеивает пиксели из множества присутствующих в видео кадров, чтобы заново смоделировать каждый момент перемещения и при этом не оставить пустых мест в изображении (так как камера движется уже по другому маршруту). Результатом является ускоренное в 10 раз видео со впечатляющей плавностью воспроизведения. Сравнение с традиционными методами стабилизации можно оценить на видео ниже. При таком результате есть, впрочем, и недостатки. Так, видео при обработке таким алгоритмом несколько теряет в качестве. Поскольку каждый кадр отрисовывается заново, иногда можно заметить, как те его части, которые в данный момент времени не присутствовали в изначальном видео, постепенно подгружаются, подобно текстурам в компьютерной игре при движении по уровню. Еще одним более очевидным недостатком разработки Microsoft Research является время, необходимое для обработки исходного видео (иными словами, требуемая вычислительная мощность). Так, по словам разработчиков, на обработку 10-минутного отрезка сейчас уходит порядка двух часов при использовании среднестатистического настольного компьютера. Впрочем, изначально та же операция занимала не менее 300 часов, поэтому можно сказать, что прогресс в оптимизации достигнут впечатляющий.

Серые прямоугольники – кадры исходного видео. Красная линия – сглаженный маршрут камеры. Серые точки – элементы 3D-модели окружающей среды, полученной путем анализа расположения объектов относительно камеры в каждом кадре В будущем Microsoft надеется создать пользовательское приложение на основе разработанного алгоритма. Возможно, поначалу оно окажется простой программой с непритязательным интерфейсом, нацеленной на использование локальных вычислительных ресурсов. Однако при наличии достаточного к ней интереса она вполне может получить дополнительную оптимизацию, а вероятно, и возможность использования облачных мощностей Windows Azure, что значительно увеличит скорость ее работы. Те, кого интересуют технические детали работы алгоритма, могут посмотреть это видео. Кроме того, полный доклад и демонстрационные ролики в высоком разрешении можно скачать на странице проекта.

Теги:

Microsoft, видео, Microsoft Research, GoPro, стабилизация.

|

|